—————————————————————-

I-Fondamentaux

II-L’IA qui manipule l’humain…

I.1-Les biais cognitifs encore & toujours.

I.2-Des faits et encore des faits.

III-Les cybercriminels qui manipulent l’IA, qui manipule l’humain…

IV-Pour finir

—————————————————————-

Beaucoup d’articles sur l’IA fleurissent, que dis-je, envahissent nos flux de renseignement. En 2022, plus de 100 000 articles ont été publiés[1], qu’en est-il, des phénomènes inconscients en cognition générés par l’IA ?

Je vais tenter d’aborder, un peu ce sujet, mais encore une fois, du côté malsain de la force.(non pas qu’il n’existe pas de bienfaits à l’IA mais ce n’est pas mon sujet)

Revenons avant tout aux fondamentaux.

Fondamentaux

Rappel sur ce qu’est :

- La psychologie cognitive. Il s’agit d’une science qui étudie les processus mentaux avancés de la cognition humaine, parmi on entend : la réflexion, la prise de décision, le raisonnement, … il existe bien d’autres processus, mais je me focaliserai sur cela.

- L’intelligence artificielle : Wikipédia l’a défini comme « un ensemble de théories et de techniques visant à réaliser des machines capables de simuler l’intelligence humaine.”

- Psychologie cognitive et IA : « La psychologie cognitive fournit un cadre pour comprendre comment les humains traitent et réagissent aux informations, et ces informations ont été utilisées pour éclairer le développement d’algorithmes et de systèmes d’IA »

- La psychologie cognitive vs l’IA : ce sujet mérite un article à lui seul, donc je ne vais pas entrer dans ce débat sans fin, je dirais simplement que les humains peuvent combiner des compétences et les appliquer à plusieurs tâches complexes. A partir d’une notion pré apprise, on va l’appliquer à un futur problème. l’IA elle, nécessitera de nouvelles données et une reprogrammation, ainsi notre cerveau fonctionne de manière analogique quand l’Ia est numérique.

L’IA qui manipule l’humain…

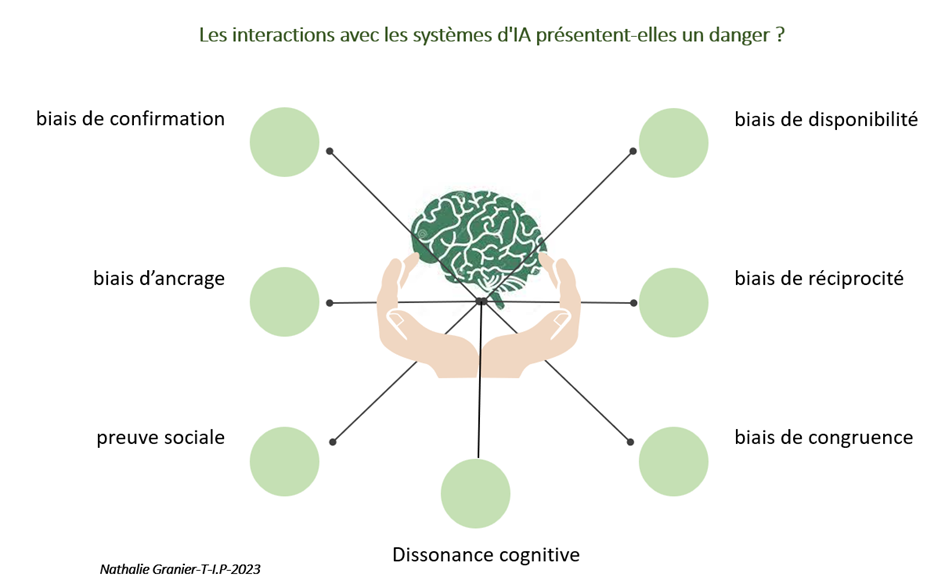

Les interactions avec les systèmes d’IA présentent-elles un danger ?

Rentrons dans le vif du sujet à présent.

Qui mérite une greffe d’organe ? Doit-on juger un individu, coupable ? Doit-on s’engager dans une guerre ?

«Les décisions les plus difficiles à prendre sont celles qui vous présentent des chemins au bout desquels vous ne serez plus la même personne. » N.Mandela.

Les décideurs chargés de répondre à ces questions sont confrontés à un sacré défi ! On sait que les décisions vont être influencées par de nombreux biais comme ; l’influence sociale, la peur, etc

(https://ti-p.fr/blog/le-piratage-cerebral-le-chemin-vers-un-manque-de-discernement/)

Comment décider sans être…influencé ? Demain, devra-t-on confier cette décision à une machine ? et si cette machine est aux mains d’un cybercriminel ?

Peu d’étude scientifique sur ce sujet en particulier, à méditer… mais certains ont creusé le sujet de l’IA.

Même si, selon certains chercheurs, beaucoup d’entre nous sont réticents à confier les décisions à l’IA[2], , et même si nous préférons les humains à l’IA dans les décisions nous concernant ; d’autres études révèlent que les sujets perçoivent l’IA comme étant plus capable d’impartialité que les humains.[3]

Surprenant résultat quand on sait que les algorithmes peuvent faire des prédictions biaisées, ou biais algorithmiques.

Les biais cognitifs encore & toujours.

On sait en effet, que l’IA peut amplifier ou atténuer certains biais cognitifs. Nous savons que nos décisions vont être façonnées par des préjugés individuels et sociétaux . Pour prendre de “bonnes” décisions nous devons nous baser sur des faits, des sources fiables, disposer d’informations précises. Mais comment peut-il en être ainsi quand nous sommes abreuvés de fake, de fausses informations crées de toutes pièces par des machines pilotées par des humains ? Quand nous recevons des milliers d’informations à la minute avec un temps de décision toujours plus court ?

Le manipulateur va ainsi se servir de l’IA pour renforcer :

• le biais de confirmation

Pour rappel ce biais consiste à privilégier les informations qui confortent nos préjugés, nos convictions.

Les systèmes de recommandation utilisés par le machine learning prédisent justement les évaluations des utilisateurs. Ce système s’appuie sur les données récupérées sur les sujets pour effectuer des prédictions sur ce qu’un utilisateur aimerait. Ainsi notre pouvoir d’abstraction de jugement objectif est biaisé.

• le biais d’ancrage

Il s’agit de surévaluer la première information que nous obtenons pour résoudre un problème. Avec l’IA, un biais peut être introduit dans les données par la manière dont elles sont sélectionnées pour être utilisées.

• la preuve sociale

Ce biais part du principe que la majorité sait mieux que la personne isolée.

Là encore, le processus d’apprentissage itératif « est utilisé pour entraîner l’algorithme pour les itérations suivantes. » Ainsi les données observées et/ou omises ne sont pas sélectionnées au hasard, mais sont les conséquences des choix que d’autres utilisateurs similaires ont aimé. Les systèmes de recommandation vont suggérer un certain contenu susceptible d’intéresser un utilisateur.

Le manipulateur va l’utiliser pour nous soumettre du contenu susceptible de nous intéresser et favoriser encore une fois la mauvaise décision, en cliquant sur un lien, en complétant un formulaire par exemple qui, bien sûr, sera vérolé.

« Dans une expérience, (des chercheurs du Data61 du CSIRO) les participants étaient amenés à cliquer sur des cases de couleur rouge ou bleue afin de gagner de la monnaie virtuelle. En l’occurrence, l’IA s’est calquée sur les choix des participants afin de les guider ensuite vers un choix spécifique et déterminé. Et ça a marché 70% du temps »[4]

Oui l’ IA peut influencer notre comportement.

• le biais de disponibilité

Il s’agit de confondre la validité d’une idée et la facilité avec laquelle cette même idée nous est venue à l’esprit. Le seul fait que l’information soit répétée sur les réseaux, donne l’illusion qu’elle est vrai.

Ou encore Le biais de Zajonc, qui a bien fonctionné lors des élections américaines de 2016, où 20% des tweets étaient des bots, difficile à distinguer d’un humain ; favorisant ainsi la manipulation. On parle de « trending topic ».

Des chercheurs de l’Université Cornell aux États-Unis, ont également mis en évidence cette capacité qu’à cette nouvelle technologie à influencer nos opinions.[5]

Le risque de la manipulation émotionnelle de masse est là! et si l’Opinion Mining s’en mêle alors c’est le pompon. Il s’agit là encore d’une machine intelligente capable de faire du traitement linguistique pour ainsi détecter les tonalités, les verbatims recueillis, et d’identifier ce que les gens pensent.

- le biais de réciprocité

Joseph Weizenbaum, un informaticien germano-américain, a pu prouver que les gens confiaient leurs secrets à ce qu’ils savaient être un programme informatique. Dans une expérience, il a pu ainsi mettre en évidence que si le robot donnait une “information personnelle” évidemment fictive, alors le sujet était susceptible de rendre la pareille en partageant des informations personnelles réelles.

- le biais de congruence

Ce biais consiste à négliger les hypothèses alternatives.

Une étude datant de 20166, menée par le Georgia Institute, sur la confiance humaine dans les robots, illustre bien ce biais.

Le robot avait pour mission, d’aider à la navigation dans un bâtiment, ses performances étaient particulièrement médiocres. Puis, lors d’une simulation de situation d’urgence, les participants devaient quitter le bâtiment, malgré les piètres performances du robot, les vingt-six participants ont obéi à l’androïde, plutôt que de partir par là où ils étaient entrés ! D’autres études ont été mené, et à chaque fois le bon sens a été tout simplement oublié. Les robots piratent ils notre confiance ?

- la dissonance cognitive

Comme nous allons le voir plus loin, l’homme sait que l’IA n’est qu’une machine, pour autant on va développer une relation très particulière avec elle et penser qu’elle a aussi des émotions. Pire encore serait de penser que l’objet a les mêmes capacités cognitives et émotionnelles que nous ; on parle là d’animisme, car de tels comportements pourraient nous pousser encore à faire des choses déraisonnables, illogiques, insensées.

- le biais de sur-confiance…en la machine ou le biais d’automatisation

A trop automatiser on s’en remet parfois, trop, aux machines, sans plus réfléchir. Sur confiance et dépendance ne font pas toujours bon ménage. Les humains sont susceptibles de surattribuer des qualités positives à l’IA. En cybersécurité cela va renforcer la confiance dans la puissance défensive des technologies et, malheureusement, souvent au détriment des comportements sécuritaires.

Quand l’indice Dow Jones a perdu près de 1 000 points en 36 minutes, en 2018, le marché a supporté une perte de plus de 1 000 milliards de dollars, due à qui ? à l’interaction des algorithmes.

Bien évidemment il existe de nombreux autres biais, facilement exploitables par l’IA.

Ce que l’on doit retenir c’est que les appareils intelligents, alimentés d’intelligence artificielle, collectent et analysent des données, permettant ainsi aux cybercriminels de générer des suggestions personnalisées, que l’on retrouve à travers des mails de phishing, des smishing, nous poussant ainsi à cliquer, à agir ! Ces systèmes, nous analysent, nous surveillent, nous scrutent, nous engagent émotionnellement.

L’objectif des attaquants étant, de permettre à des ordinateurs de simuler la cognition humaine, de créer une interaction émotionnelle entre les personnes et les machines, c’est-à-dire : reconnaitre les émotions, comprendre les sentiments humains, afin de manipuler la réflexion et nous pousser ainsi à prendre la mauvaise décision.

Des chercheurs de l’Université Cornell aux États-Unis, ont mis en évidence cette capacité qu’à cette nouvelle technologie à influencer nos opinions.[6]

Déjà à la fin des année 70, le fameux « alphaGo » de « deepmind »(petit rappel, l’ordinateur a vaincu le joueur de Go 9 dan Lee Sedol ou bien est-ce l’humain qui a été décontenancé, et s’est égaré par erreur ?), essayait de simuler le comportement humain, de comprendre ses croyances, ses intentions, et anticiper ses comportements (https://fr.wikipedia.org/wiki/Th%C3%A9orie_de_l%27esprit)

Deepmind n’avait rien en soi de malsain, mais comme toute technologie, elle peut être utilisée à des fins maléfiques, immorales. N’oublions pas que l’IA est fabriquée par des Humains avec nos faiblesses et nos zones les plus sombres.

Des faits et encore des faits.

Pour clore ce chapitre, voici quelques études et faits d’actualité intéressants :

• La première est celle du psychologue Yochanan Bigman[7] qui a révélé que « les gens sont moins scandalisés moralement par la discrimination sexuelle causée par un algorithme par opposition à la discrimination créée par les humains »

Cette même étude a révélé que les participants « estimés que les entreprises étaient moins responsables légalement de la discrimination algorithmique. »

• Dans une autre étude, Bigman[8] s’est intéressé aux perceptions de la justice entre les employés « humains » et des robots dans un hôtel Malaisien. A la fin de l’expérience, les participants ont traité les travailleurs humains avec moins de respect que les robots.

Comme promis, parlons anthropomorphisme, qui consiste en notre capacité à donner des traits humains à des objets.

« Je n’aurais jamais cru qu’un programme aussi simple puisse provoquer chez des gens normaux de tels délires. »

Weizenbaum

-Selon une étude menée en Allemagne, des personnes se sont laissées apitoyer par le robot « Nao » qui les implorait de ne pas l’éteindre[10]. Pour justifier cette action, les participants ont répondu « Il m’a dit qu’il avait peur de ne pas être allumé de nouveau et cela m’a touché… »

-En 1996, Byron Reeves et Clifford Nass, ont mis en évidence que nous…parlions à nos appareils : téléviseurs, ordinateurs, robots… Votre voiture n’a-t-elle pas un petit nom d’ailleurs ? Oui, beaucoup de gens ont des relations sociales avec leurs robots domestiques. Nous avons même…de l’empathie. C’était le cas d’un colonel de l’armée américaine qui a refusé d’envoyer son robot anti-mines se faire exploser, pour ne pas « lui faire mal ».

-Selon Masahiro Mori, plus une créature nous ressemble, plus ses défauts vont nous paraître horribles.

– Autre histoire, autre lieu. Un Canadien a discuté pendant plusieurs mois avec un de ses systèmes imitant sa petite amie décédée.[11] L’histoire ne dit pas si cela l’a aidé à faire son deuil :/

– Est ce que j’évoque le cas de ELIZA, le chatbot soupçonné d’avoir poussé un Belge au suicide[12], ? Alors je me pose la question de savoir si : Replika , la « cousine de « Eliza » qui fournit une amitié virtuelle pour soutenir les personnes qui traversent la dépression, l’anxiété, avec son oncle « Youper » qui lui consiste à accompagner dans le traitement du stress, de l’anxiété et la dépression, sans oublier Woebot, qui lui est le psy de toute la famille « chatbot » qui conseille à grand renfort de solutions inspirées de la thérapie cognitivo-comportementale,… j’en arrive à ma question… ; toute cette fratrie aurait-elle pu aider ? (ironie quand tu nous tiens)

Laurence Devillers, spécialiste en IA émotionnelle au CNRS « rappelle que les IA ne peuvent détecter que les six émotions les plus primaires que sont la peur, la colère, le dégoût, la joie, la tristesse et la surprise »

Les robots anthropomorphes sont une technologie émotionnellement persuasive et donc potentiellement dangereuse. Les robots pourraient nous persuader de faire des choses. Ils pourraient nous faire peur, exercer des pressions , nous encourager à prendre plus de risques[13] et …Même nous faire signer un contrat de mariage, comme ce fut le cas pour Akihiko Kondo en 2018… bref je m’égare.

Ces exemples, certes éloignés de notre monde cyber, prouvent donc, notre capacité à être influencé, et à en oublier toutes logiques et ça nos chers cybercriminels adorent.

Les cybercriminels qui manipulent l’IA, qui manipule l’humain…

Il ne s’agit pas ici d’évoquer et de ré évoquer les nombreuses attaques cyber, effectuée avec l’IA, comme le phishing de plus en plus personnalisé, et convaincant, ou la création de logiciel malveillant ; ou encore des attaques par des robots corrompus sur un système de trading de cryptomonnaies[14].; mais plus de voir en quoi l’IA permet aux cybercriminels d’exploiter les vulnérabilités humaines.

Parmi les très nombreuses perfidies, on peut citer :

- le clonage vocal en temps réel. 5 secondes ont suffi à une entreprise anglaise pour voir disparaitre 200 000 livres sterling sur un compte bancaire hongrois.

L’IA va permettre de modifier la prononciation des mots, le ton de la voix, les émotions. Le cybercriminel pourra ainsi appeler sa victime ou ses proches sur la base de la familiarité de la voix, pour obtenir ce qu’il souhaite.[15]

Le groupe russe CyberBerkut a déjà utilisé des modèles d’IA entraînés sur la voix de personnes réelles.[16]

- après la voix, le visage. Le visage d’Elon Musk, a été utilisé pour escroquer les futures victimes, qui n’ont pas vu le leurre et ont envoyé des crypto-monnaies Bitcoin et Ethereum aux cybercriminels.

- ChatGPT, l’outil rend les messages plus authentiques et donc beaucoup plus susceptibles de réussir en tant que base d’une attaque.

Exemple via les GAN : Generative Adversarial Networks qui “sont utilisés pour apprendre à l’IA à recréer des styles artistiques, des jeux vidéo ou même des photos.”

Parfois même les cybercriminels récupèrent des données sur un plateau, c’est le cas, quand un médecin saisit le nom d’un patient et les détails de son état dans l’outil, lui évitant ainsi de rédiger lui-même une lettre à la compagnie d’assurance ; ou encore lorsqu’un cadre saisit des données de son entreprise pour effectuer son slide PowerPoint !

- le combo web scraping et IA. Les robots alimentés de machine learning sont désormais capable d’imiter le comportement humain pour voler et tromper les CAPTCHA dans le but de d’extraire plus de données dans un temps record. Voilà les cybercriminels n’ont plus qu’a cueillir les données sensibles qui arrivent en masse.

Les cybercriminels automatisent les premières étapes d’une attaque à savoir la phase de reconnaissance, en générant du contenu, en améliorant la collecte de renseignements, le tout de façon automatique. Cela leur permet un gain de temps, plus de données récoltées et des données plus précises. Ils vont ainsi savoir ce que nous aimons, détestons, ce qui nous fait réagir alors oui ils le faisaient avant mais désormais c’est du fordisme !

On va devoir s’attendre à ce que les technologies d’IA transforment la nature des cyberattaques ; et c’est déjà le cas.

Finalement les cybercriminels nourrissent l’IA pour parfaire leurs attaques et l’IA le leur rend bien.

Pour finir

Que se passera-t-il demain, lorsque l’on sait que dès aujourd’hui, l’IA est capable de prouesse ?

- Des chercheurs de l’Université de Berkeley, ont mis au point une intelligence artificielle capable de « lire » dans nos pensées. Ils ont pu, en effet, concevoir une machine, basée sur l’apprentissage automatique, capable de deviner la musique qu’une personne était en train d’écouter.

- En mai 2023, des scientifiques de l’Université du Texas ont réussi à déchiffrer les pensées d’individus en s’appuyant sur les images fournies par un scanner IRM. Dans un autre cas, une femme paralysée a pu acquérir l’usage de la parole grâce à une interface cerveau-machine

- Neuralink ? Synchron ? Utah Array ? non je n’en parle même pas[17]

Ces recherches sont en soient, de belles inventions médicales, mais entre de mauvaises mains, cela donnera quoi ?

De nombreuses interrogations en découlent :

- Les systèmes d’IA ne devraient-elles pas nous aider à atténuer nos biais ?

- Les IA préventives vont-elles nous prévenir que nous sommes manipulés ?

L’utilisation d’algorithmes devraient débiaiser les procédures de prise de décision en supprimant la subjectivité humaine, les systèmes « human-in-the-loop » tentent bien des recommandations pour atténuer ces biais, mais il semblerait que cela soit encore à ce stade insuffisant.

Les systèmes d’IA deviennent de plus en plus performants ; les cybercriminels les exploitent et ces risques d’utilisation abusive intentionnelle ont de beaux jours devant eux. Ce n’est pas seulement la vitesse de piratage qui va être impactée, c’est aussi l’échelle, la portée, sommes-nous prêts à cela ?

“By far, the greatest danger of Artificial Intelligence is that people conclude too early that they understand it.”

“Le plus grand danger de l’intelligence artificielle est, de loin, que les gens concluent trop tôt qu’ils la comprennent.

Spike Jonze

Nathalie Granier-août 2023

Sources

Bruce Schneier- The Coming AI Hackers-2021

Ella Glikson -Human Trust in Artificial Intelligence: Review of Empirical Research-2018

Araujo, T., Helberger, N., Kruikemeier, S., & de Vreese, C. H. (2020). In AI we trust? Perceptions about automated decision-making by artificial intelligence.

Peter Ludes -Algorithms of Power: Key Invisibles – 2011

Howard Rheingold -Tools for Thought: The History and Future of Mind-Expanding-2000

Joseph Weizenbaum-Die Macht der Computer und die Ohnmacht der Vernunft-1978

Carlson, R., Bigman, Y. E., Gray, K., Ferguson, M. & Crockett, M. (2022). A motive-centered approach to moral judgment. Accepted for publication at Nature Reviews: Psychology.

Bigman, Y.E., Wilson, D., Arnestad, M., Waytz, A., & Gray, K. (2022). Algorithmic discrimination causes less moral outrage than human discrimination.

Horstmann AC, Bock N, Linhuber E, Szczuka JM, Straßmann C, Krämer NC (2018) Do a robot’s social skills and its objection discourage interactants from switching the robot off?

[1] AI Index Report 2023

[2] Glikson, Human Trust in Artificial Intelligence: Review of Empirical Research

[3] Araujo, T., Helberger, N., Kruikemeier, S., & de Vreese, C. H. (2020). In AI we trust? Perceptions about automated decision-making by artificial intelligence.

[4] https://www.pnas.org/doi/10.1073/pnas.2016921117

[6] https://www.01net.com/actualites/lia-est-capable-de-vous-manipuler-cette-etude-le-prouve.html

[7] Carlson, R., Bigman, Y. E., Gray, K., Ferguson, M. & Crockett, M. (2022). A motive-centered approach to moral judgment. Accepted for publication at Nature Reviews: Psychology.

[8] Bigman, Y.E., Wilson, D., Arnestad, M., Waytz, A., & Gray, K. (2022). Algorithmic discrimination causes less moral outrage than human discrimination.

[9] https://up-magazine.info/en/le-vivant/neurosciences/118638-des-puces-dans-le-cerveau/

[10] https://opportunites-technos.com/non-eteignez-pas-dit-robot/

[11] https://www.sfchronicle.com/projects/2021/jessica-simulation-artificial-intelligence/

[12] https://www.bfmtv.com/tech/intelligence-artificielle/j-aimerais-te-voir-mort-eliza-l-ia-qui-aurait-conduit-un-homme-au-suicide_AV-202303300439.html

[13] Bruce Schneier- The Coming AI Hackers-2021

[14] https://journalducoin.com/defi/34-millions-dollars-3-mois-robot-rafle-cryptos/

[15] http://www.uniindia.com/ai-based-voice-cloning-new-cyber-crime-threat-stay-alert-jammu-cyber-police-stn/north/news/3032978.html

[16] https://www.mandiant.com/resources/blog/gru-rise-telegram-minions

[17] https://amp.cnn.com/cnn/2023/08/08/tech/neuralink-brain-musk-fundraising-founders-fund/index.html– https://amp.france24.com/fr/info-en-continu/20230526-la-start-up-neuralink-de-musk-va-tester-ses-implants-c%C3%A9r%C3%A9braux-sur-des-humains

Source image: erick-butler